Cuando los sistemas fallan a las 3 de la mañana, los logs son la única luz que guía a los ingenieros hacia la solución. Esta es la historia técnica de cómo construir una arquitectura de logging que no solo sobrevive en producción, sino que se convierte en tu ventaja competitiva.

Introducción: El Síndrome del "Internal Server Error"

En mi experiencia trabajando en varias empresas tecnológicas, me he encontrado repetidamente con el mismo patrón destructivo: hay servicios legacy que han crecido orgánicamente durante años, desarrollados por equipos que priorizaron la velocidad de desarrollo sobre la operabilidad. Estos sistemas, cuando fallan, devuelven el temido error HTTP 500 con el icónico mensaje "Internal Server Error", dejando a los equipos de soporte completamente ciegos ante la causa raíz del problema.

Esta situación no es académica ni infrecuente. Es la realidad diaria en empresas que manejan millones de usuarios y cientos de servicios. Cuando un sistema crítico empieza a fallar silenciosamente, cada minuto de caída se traduce en pérdidas directas de ingresos y erosión de la confianza del usuario. Sin logs estructurados y contextuales, esos minutos se convierten en horas de investigación desesperada a través de múltiples sistemas, bases de datos, y equipos de desarrollo.

Loading diagram...

La Arquitectura del Caos: Cuando los Logs No Existen

Los sistemas sin estrategia de logging coherente exhiben patrones predecibles de fallo. He observado cómo servicios aparentemente estables empezaban a mostrar degradación de rendimiento y aumentos en la tasa de errores sin que nadie en la organización lo detectara hasta que los usuarios comenzaban a reportar problemas masivamente.

En múltiples proyectos hemos experimentado exactamente esta situación. Los servicios legacy empiezan a mostrar latencias durante picos de tráfico, y sin logs estructurados, el proceso de investigación se convierte en arqueología digital: correlacionar manualmente logs de aplicación con logs de base de datos, métricas de infraestructura, y datos de monitoreo para reconstruir qué está pasando realmente.

Problemas como pools de conexiones mal configurados que bajo carga específica entran en bloqueos pueden tomar días identificar sin la infraestructura apropiada. Esos días representan no solo tiempo de ingeniería dedicado a la investigación, sino también el coste de oportunidad de funcionalidades no desarrolladas, fricción en la experiencia de usuario, y riesgo reputacional.

Los Fundamentos de la Ingeniería de Logging

Diseño de Sistemas: Logging como Ciudadano de Primera Clase

Desde una perspectiva de ingeniería de sistemas, el logging debe ser tratado como un componente arquitectónico de primera clase, no como una consideración posterior. Esto significa que las decisiones sobre qué, cuándo, y cómo registrar información deben tomarse durante la fase de diseño del sistema, no durante la implementación o, peor aún, durante la resolución de incidentes.

Loading diagram...

El Problema de la Correlación en Sistemas Distribuidos

En arquitecturas distribuidas modernas, una sola operación de usuario puede involucrar decenas de servicios diferentes. Cuando esa operación falla, necesitas una manera de correlacionar eventos a través de múltiples servicios para reconstruir la secuencia completa.

Loading diagram...

Sin IDs de correlación apropiados, cuando un usuario reporta que su checkout falló, tendrías que buscar manualmente en logs de 5 servicios diferentes para reconstruir qué pasó. Con IDs de correlación, una sola consulta te devuelve toda la secuencia de eventos relacionados.

Anatomía de un Log Entry Perfecto

Un log entry bien diseñado captura no solo qué pasó, sino el contexto completo necesario para entender por qué pasó:

{

"timestamp": "2025-09-07T15:30:45.123Z",

"level": "ERROR",

"service": "payment-service",

"version": "2.3.1",

"environment": "production",

"correlationId": "txn_67890abc-def1-2345",

"userId": "user_123456",

"operation": "ProcessPayment",

"message": "Procesamiento de pago falló: fondos insuficientes",

"error": {

"type": "InsufficientFundsException",

"message": "Saldo de cuenta (150.00) insuficiente para transacción (200.00)"

},

"context": {

"paymentMethod": "credit_card",

"amount": 200.00,

"currency": "EUR",

"processing_time_ms": 1250

}

}

Arquitecturas de Logging Escalables

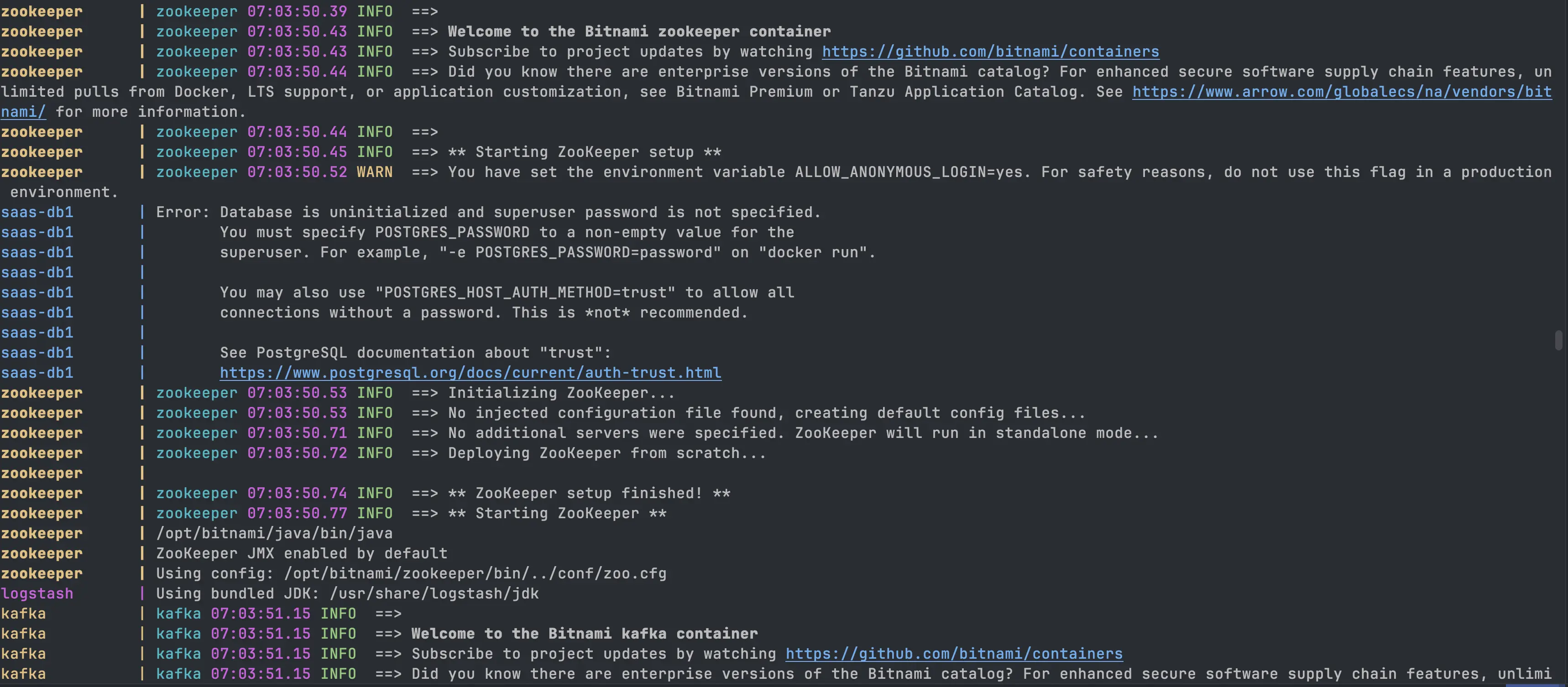

El Pipeline ELK: Ingeniería de Datos en Tiempo Real

La arquitectura ELK (Elasticsearch, Logstash, Kibana) ha demostrado su valor en organizaciones que manejan terabytes de logs diarios, pero su implementación exitosa requiere entender profundamente las características de cada componente.

Loading diagram...

Filebeat: La Primera Línea de Defensa

Filebeat actúa como la primera línea de defensa contra la pérdida de datos en tu pipeline de logging. Su configuración debe ajustarse cuidadosamente según las características específicas de tu sistema. El parámetro close_inactive determina cuándo Filebeat deja de monitorear un archivo que no ha tenido actividad reciente - un valor demasiado bajo puede causar overhead innecesario, mientras que un valor demasiado alto puede mantener handles de archivo abiertos durante mucho tiempo.

La gestión de logs multilínea requiere atención especial. Los stack traces de Java, por ejemplo, abarcan múltiples líneas pero representan un solo evento lógico. La configuración incorrecta de patrones multilínea puede resultar en stack traces fragmentados.

Logstash: El Cerebro del Pipeline

Logstash funciona como el centro de procesamiento inteligente donde los logs en crudo se transforman en datos estructurados útiles. Su arquitectura de plugins permite implementar lógica compleja que incluye enriquecimiento con datos externos, normalización de formatos diversos, y implementación de reglas de negocio específicas.

Un error común es tratar cada entrada de log de manera aislada. En realidad, muchos insights valiosos emergen de la correlación temporal entre eventos. Por ejemplo, detectar que un servicio específico comenzó a mostrar alta latencia justo después de que otro servicio experimentara errores de conexión a la base de datos.

OpenTelemetry: La Evolución Hacia Observabilidad Unificada

OpenTelemetry representa un cambio paradigmático hacia observabilidad unificada, donde logs, métricas, y trazas se correlacionan automáticamente:

Loading diagram...

La ventaja fundamental radica en la propagación automática de contexto. Cuando se crea un span de traza en un servicio, el contexto se propaga automáticamente a servicios downstream, permitiendo que logs generados durante el procesamiento se correlacionen automáticamente con la traza correspondiente.

Estrategias Avanzadas de Sampling y Rendimiento

Sampling Inteligente: Optimización vs. Completitud

En sistemas de alto rendimiento, registrar cada evento no es técnica ni económicamente viable. El sampling inteligente permite mantener visibilidad suficiente para la depuración mientras controla el volumen de datos:

Loading diagram...

La estrategia de muestreo debe ser contextual y adaptativa. Los errores siempre se registran completamente porque representan situaciones que requieren investigación. Los warnings de servicios críticos tienen prioridad sobre warnings de servicios auxiliares.

Logging Asíncrono y Optimización de Rendimiento

El logging asíncrono mejora la latencia de tu aplicación principal, pero puede introducir problemas si no se configura correctamente:

<configuration>

<appender name="ASYNC_FILE" class="ch.qos.logback.classic.AsyncAppender">

<queueSize>2048</queueSize>

<discardingThreshold>0</discardingThreshold>

<neverBlock>false</neverBlock>

<includeCallerData>false</includeCallerData>

<appender-ref ref="FILE"/>

</appender>

<appender name="FILE" class="ch.qos.logback.core.rolling.RollingFileAppender">

<encoder class="net.logstash.logback.encoder.LoggingEventCompositeJsonEncoder">

<providers>

<timestamp/>

<logLevel/>

<mdc/>

<message/>

<stackTrace/>

</providers>

</encoder>

<rollingPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedRollingPolicy">

<fileNamePattern>/var/log/myapp/application.%d{yyyy-MM-dd}.%i.log.gz</fileNamePattern>

<maxFileSize>100MB</maxFileSize>

<maxHistory>30</maxHistory>

<totalSizeCap>5GB</totalSizeCap>

</rollingPolicy>

</appender>

</configuration>

Implementación Práctica: Biblioteca de Logging para Spring Boot

Muchas empresas modernas utilizan librerías de observabilidad especializadas para poder replicar y estandarizar el logging en diferentes servicios. Estas librerías permiten mantener coherencia en la instrumentación a través de múltiples equipos y proyectos.

Para demostrar estos conceptos en acción, examinemos una implementación de una biblioteca de logging muy simple que yo mismo he desarrollado. Es básicamente un proyecto de Spring Boot que utiliza una clase auto-configuración para registrar los logs de una aplicación. El código completo está disponible en este repositorio.

Arquitectura de la Biblioteca

Loading diagram...

La biblioteca implementa logging centralizado con integración básica de OpenTelemetry para distributed tracing, usando auto-configuración de Spring Boot para cargar automáticamente la configuración de Logback y enviar logs tanto a consola (con colores) como a Logstash mediante TCP.

Casos de Uso Reales y Arquitecturas de Referencia

Netflix: Logging a Escala de Streaming Global

Netflix procesa más de 8 billones de eventos de logging por día, generados por cientos de microservicios que atienden a más de 200 millones de usuarios globalmente:

Loading diagram...

Netflix desarrolló "logging contextual" donde cada evento incluye no solo información técnica sino también contexto de negocio relevante. Un evento de error en el servicio de reproducción incluye información sobre el contenido que se estaba reproduciendo, la calidad de video seleccionada, y métricas de red del usuario.

Herramientas y Ecosistema Moderno

Evolución de Formatos de Logging

Loading diagram...

JSON ha emergido como el formato dominante para logging estructurado debido a su balance entre legibilidad humana y procesamiento automatizado. Para sistemas con volumen extremadamente alto, formatos binarios como Protocol Buffers ofrecen ventajas significativas en tamaño y velocidad.

Distributed Tracing: Más Allá del Logging Tradicional

Distributed tracing representa una evolución fundamental en observabilidad para sistemas distribuidos. Mientras que logs tradicionales capturan eventos discretos en el tiempo, distributed tracing reconstruye el flujo completo de ejecución de una operación a medida que atraviesa múltiples servicios, proporcionando una vista holística del comportamiento del sistema.

La diferencia clave radica en la correlación temporal y causal. Un log te dice que algo ocurrió; una traza te muestra por qué ocurrió y cómo se relaciona con otros eventos. Esta distinción es crítica para la depuración en arquitecturas de microservicios donde una sola operación de usuario puede generar cientos de eventos distribuidos a través de decenas de servicios.

Anatomía de una Traza Distribuida:

Una traza completa incluye múltiples spans (segmentos de trabajo), cada uno representando una unidad de trabajo en un servicio específico. Los spans mantienen relaciones padre-hijo que permiten reconstruir la secuencia de ejecución completa, incluyendo operaciones paralelas y dependencias complejas.

// Ejemplo de instrumentación manual con OpenTelemetry

@RestController

public class PaymentController {

private final Tracer tracer = GlobalOpenTelemetry.getTracer("payment-service");

@PostMapping("/process")

public ResponseEntity<PaymentResponse> processPayment(@RequestBody PaymentRequest request) {

Span span = tracer.spanBuilder("payment.process")

.setAttribute("payment.amount", request.getAmount())

.setAttribute("payment.currency", request.getCurrency())

.setAttribute("user.id", request.getUserId())

.startSpan();

try (Scope scope = span.makeCurrent()) {

// Procesamiento que automáticamente hereda el contexto de traza

PaymentResponse response = paymentService.processPayment(request);

span.setStatus(StatusCode.OK);

span.setAttribute("payment.status", response.getStatus());

return ResponseEntity.ok(response);

} catch (PaymentException e) {

span.setStatus(StatusCode.ERROR, e.getMessage());

span.recordException(e);

throw e;

} finally {

span.end();

}

}

}

Ventajas del Distributed Tracing:

- •Visibilidad de Latencia: Identifica exactamente qué servicio o operación contribuye más a la latencia total

- •Debugging de Dependencias: Rastrea cómo fallos en un servicio se propagan a servicios dependientes

- •Análisis de Carga: Comprende patrones de tráfico y cuellos de botella en tiempo real

- •Optimización de Rendimiento: Identifica oportunidades para paralelización y optimización de consultas

Loading diagram...

Antipatrones y Trampas Comunes

El Antipatrón de "Registrar Todo"

El antipatrón de "registrar todo" surge típicamente de la falsa creencia de que más datos siempre equivalen a mejor observabilidad. En realidad, el exceso de logging no estructurado puede degradar significativamente la capacidad de depuración y crear problemas operacionales serios.

Síntomas del Antipatrón:

- •Logs de comprobaciones de estado cada segundo generando millones de entradas irrelevantes

- •Logging de cada query SQL sin considerar el volumen en sistemas de alta transacción

- •Stack traces completos para excepciones esperadas como validaciones de entrada

- •Logging de datos sensibles sin políticas de sanitización

- •Niveles de log incorrectos (usando INFO para depuración detallada)

Impacto Real en Producción:

Hemos visto múltiples casos donde se implementa logging exhaustivo "para estar seguros" durante el desarrollo inicial. Cuando estos sistemas llegan a producción con alto volumen de transacciones, los pipelines de logging colapsan:

- •Los costes de almacenamiento se multiplican exponencialmente

- •Las consultas de depuración tardan minutos en lugar de segundos

- •El ruido oculta eventos críticos como fallos de autorización

- •Los cuadros de mando se vuelven inutilizables por la sobrecarga de datos

La solución típicamente requiere una refactorización completa de la estrategia de logging, implementando sampling inteligente y niveles contextuales. Por esto, desde Caricalia diseñamos sistemas escalables pensados para las necesidades específicas de cada negocio, cuidando hasta estos detalles técnicos que el cliente no ve, pero que son críticos para el éxito del proyecto.

Loading diagram...

El exceso de logging crea paradójicamente menos visibilidad porque los eventos importantes se ocultan en el ruido de eventos irrelevantes.

Logging Síncrono en el Camino Crítico

Realizar operaciones de logging síncronamente en el camino crítico puede introducir latencia significativa. He visto sistemas donde una latencia promedio de respuesta de 200ms se degradaba a 800ms debido a logging síncrono que incluía llamadas de red a servicios de logging externos.

Métricas y Observabilidad: La Trinidad Completa

Logs, Métricas, y Trazas: Perspectivas Complementarias

La observabilidad moderna se basa en tres pilares que proporcionan perspectivas complementarias:

Loading diagram...

Los logs proporcionan contexto detallado sobre eventos específicos pero pueden ser costosos a gran escala. Las métricas capturan agregaciones numéricas eficientes para cuadros de mando y alertas. Las trazas muestran el flujo de ejecución a través de sistemas distribuidos.

Consideraciones de Seguridad y Compliance

Logging en Entornos Regulados

Los entornos regulados como finanzas (PCI DSS, SOX), salud (HIPAA), y servicios gubernamentales presentan desafíos únicos para arquitecturas de logging. Estos no son simplemente restricciones técnicas, sino requisitos legales donde el incumplimiento puede resultar en multas millonarias y consecuencias penales.

Desafíos Específicos de Compliance:

1. Clasificación Automática de Datos Los sistemas deben identificar y clasificar automáticamente datos sensibles en logs. Un número de tarjeta de crédito accidentalmente loggeado puede violar PCI DSS, mientras que información médica no protegida viola HIPAA.

@Component

public class SensitiveDataSanitizer {

private static final Pattern CREDIT_CARD = Pattern.compile("\\b\\d{4}[\\s-]?\\d{4}[\\s-]?\\d{4}[\\s-]?\\d{4}\\b");

private static final Pattern SSN = Pattern.compile("\\b\\d{3}-\\d{2}-\\d{4}\\b");

public String sanitize(String message) {

String sanitized = CREDIT_CARD.matcher(message)

.replaceAll("****-****-****-" + "$0".substring(Math.max(0, "$0".length() - 4)));

return SSN.matcher(sanitized)

.replaceAll("***-**-****");

}

}

2. Cadena de Custodia Digital En sectores financieros, los logs pueden ser evidencia legal en auditorías o investigaciones. Esto requiere:

- •Integridad criptográfica: Hash chains que demuestran que logs no han sido modificados

- •Timestamps precisos: Sincronización con fuentes de tiempo autoritativas (NTP)

- •Acceso auditado: Registro de quién accedió a qué logs y cuándo

3. Retención Diferenciada Diferentes tipos de eventos requieren diferentes períodos de retención:

- •Transacciones financieras: 7 años (requisitos fiscales)

- •Accesos administrativos: 3 años (auditorías de seguridad)

- •Datos de salud: Varía por jurisdicción, hasta permanente en algunos casos

- •Datos de menores: Borrado inmediato al alcanzar mayoría de edad (GDPR)

4. Jurisdicción y Soberanía de Datos Los logs pueden contener datos sujetos a diferentes jurisdicciones. Un banco europeo con clientes en múltiples países debe asegurar que logs se almacenen en jurisdicciones apropiadas y cumplan con regulaciones locales.

Arquitectura de Referencia para Compliance:

Loading diagram...

Implementación en Proyectos Reales:

En proyectos que requieren compliance estricto, implementamos sistemas donde cada log entry incluye metadatos de clasificación que determinan automáticamente:

- •Nivel de cifrado requerido

- •Período de retención

- •Controles de acceso aplicables

- •Jurisdicción de almacenamiento

Estos sistemas pueden procesar millones de eventos diarios con clasificación automática en tiempo real, manteniendo compliance con múltiples regulaciones simultáneamente. Desde Caricalia, desarrollamos estas arquitecturas cuidando cada detalle técnico para asegurar que nuestros clientes cumplan con todos los requisitos normativos de su industria.

Consideraciones Clave para Implementación:

GDPR, HIPAA, y otras regulaciones imponen restricciones sobre manejo de datos que deben considerarse desde la fase de diseño, no como una consideración posterior. La implementación exitosa requiere colaboración estrecha entre equipos legales, de compliance, y técnicos desde las primeras fases del proyecto.

Conclusiones: La Ingeniería Detrás de la Observabilidad

El logging en producción trasciende la simple captura de eventos para convertirse en una disciplina de ingeniería completa que requiere consideración cuidadosa de arquitectura, rendimiento, costes, seguridad, y requisitos operacionales.

Lecciones Clave de la Industria

Las empresas más exitosas en observabilidad han aprendido que logging no puede tratarse como una consideración posterior. Debe ser considerado desde la fase de diseño, con aportaciones de ingeniería, operaciones, seguridad, y partes interesadas del negocio.

La evolución desde monitoreo reactivo hacia observabilidad predictiva representa un cambio fundamental en cómo conceptualizamos la confiabilidad del sistema. En lugar de simplemente responder a fallos cuando ocurren, los sistemas modernos pueden predecir y prevenir muchas clases de problemas antes de que impacten a los usuarios.

El Coste de No Invertir en Logging

He visto organizaciones donde la falta de estrategia apropiada de logging resultó en:

- •Tiempo Medio de Resolución (MTTR) de horas en lugar de minutos para incidentes críticos

- •Incapacidad para análisis de causa raíz de degradaciones sutiles de rendimiento

- •Violaciones de compliance debido a pistas de auditoría insuficientes

- •Velocidad de desarrollo reducida porque los ingenieros pasan más tiempo depurando que desarrollando funcionalidades

Perspectivas Futuras

La convergencia de AI, arquitectura cloud-native, y edge computing está creando nuevos desafíos y oportunidades para sistemas de logging. Los dispositivos edge pueden requerir toma de decisiones autónoma sobre qué eventos registrar basándose en condiciones locales.

La industria se está moviendo hacia plataformas de observabilidad unificadas que correlacionan logs, métricas, trazas, y eventos de negocio en vistas unificadas que permiten tanto resolución técnica de problemas como generación de insights de negocio.

Recomendaciones para Equipos de Ingeniería

Empieza con Estrategia: Define qué preguntas necesitas responder antes de decidir qué datos capturar. Logging sin propósito genera coste sin valor.

Invierte en Herramientas: La infraestructura apropiada de logging paga dividendos exponencialmente. El tiempo ahorrado en futuras sesiones de depuración justifica una inversión inicial significativa.

Estandariza con Librerías: Utiliza librerías de observabilidad que permitan replicar y estandarizar el logging en diferentes servicios, manteniendo coherencia a través de múltiples equipos.

Trata los Logs como Datos: Aplica el mismo rigor al diseño de schema de logs que aplicarías al diseño de schema de base de datos.

Automatiza Todo: El análisis manual de logs no escala. Invierte en automatización para alertas, correlación, y resolución básica de problemas.

Planifica para Escala: Diseña tu arquitectura de logging para manejar 10 veces el volumen actual. El crecimiento en datos de logging a menudo supera el crecimiento de la aplicación.

El Enfoque de Caricalia

En Caricalia, entendemos que el logging es una pieza fundamental de cualquier sistema escalable. Por eso, desde la fase de diseño, implementamos arquitecturas de observabilidad robustas que incluyen:

- •Instrumentación automática con librerías especializadas

- •Correlación de eventos a través de sistemas distribuidos

- •Sampling inteligente para optimizar costes sin perder visibilidad

- •Compliance by design para industrias reguladas

- •Dashboards operacionales que facilitan la resolución de incidentes

Estos detalles técnicos, aunque invisibles para el usuario final, son críticos para el éxito operacional del proyecto. Cuidamos cada aspecto de la arquitectura para asegurar que nuestros clientes tengan sistemas confiables, escalables, y fáciles de mantener.

El futuro de la ingeniería de software está inextricablemente ligado con nuestra capacidad para entender y depurar sistemas distribuidos complejos. El logging no es solo una necesidad operacional; es capacidad estratégica que permite a las organizaciones innovar con confianza, responder rápidamente a problemas, y mantener la confianza del usuario en un mundo cada vez más digital.